La segunda parte de la jornada de formación a jóvenes investigadores que se desarrolló en la Complutense se dedicó a los datos de la investigación y su gestión; así como a los derechos de autor que pudieran estar relacionados. En ella intervinieron Luis Martínez Uribe, Javier de la Cueva y Juan Pavón.

Se puede ver la grabación en Youtube https://www.youtube.com/watch?v=Zos3UFJ6MDo&list=UUjQQ05hXkKokuGULJRvxiUA)

Luis Martínez Uribe comenzó asegurando que el poder de computación es cada vez mayor y quienes tienen dinero como el CERN podría decirse que vomitan datos, mientras que el resto podría considerarse la Long Tail of Science.

Avanza haciéndose preguntas:

- ¿Qué son los datos? Difícil definirlos. Cuanto más abierta la percepción, mejor. Ya hay lugares en los que los datos se consideran como evidencia (Monash) da igual su formato, resultado de experimentos, observaciones... Nos muestra un listado de formatos y objetos que no puede considerarse completo.

- ¿Por qué hay que gestionarlos de manera adecuada? Hay varias razones. La primera, para no perderlos. La segunda asegurar la reproducibilidad (que sea verdad, no nos inventemos cosas). También la transparencia y la reutilización (si ya se han creado, no volver a crear). Además que nos van a pedir que hagamos cosas con nuestros datos (requisitos de agencias).

En Horizon 2020 se ha pedido que se incluya un plan de gestión de datos en la propuesta: esto es una revolución. Cómo tratarlos, formatos, guardarlos, documentarlos...

También piden que los datos se compartan. No sólo los financiadores. También revistas y editores. Dryad, PLOS, Nature, Data Citation Index, Journal of Political Economy.

Y las universidades también deberían requerirlo (ya empieza a haberlas en extranjeras: Edinburgh University Data Policy 2011). A cambio sería conveniente que las universidades proporcionen servicios de apoyo.

Es además un reto de los investigadores: nuestros propios datos, documentarlos (parte que más gusta a las bibliotecas), transformarlos e integrarlos, visualizarlos y analizarlos, publicarlos y compartirlos.

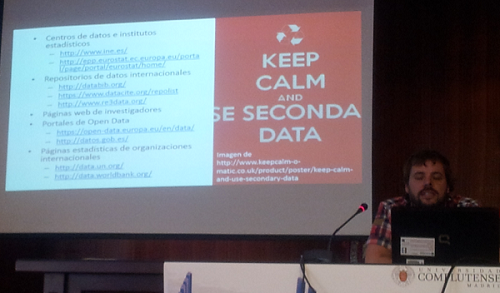

Cuando se habla de open data él siempre piensa que la parte de publicación es la final y hay muchos pasos previos. Es un poco inútil hablar de ella sin tener en cuenta lo primero. Por eso seguramente hablar de open data no es lo prioritario. - ¿Dónde encontrar datos secundarios?

- Centros de datos e institutos estadísticos son los primeros: CIS, INE, Eurostat.

- Repositorios de datos institucionales, organizados por disciplinas: Databib, Datacite, R3data.

- Páginas web de investigadores.

- Portales de Open Data: todos son fiables (en España uno por C.A.): Unión Europea.

- Estadísticas de organizaciones internacionales: Naciones Unidas, Banco Mundial.

Luego asocia diferentes actividades que se hacen con los datos con herramientas que lo facilitan:

- Crear y almacenar datos. Posibilidades muy creíbles de hacerlo con las herramientas actuales. Ej. SurveyMonkey, GoogleForms...instrumentos con Open Source Hardware (microcontroladores abiertos, impresoras 3-D...) Sensorca.

Organizar los datos: Research Data Mantra-Organising data.

Lo más importante es el sentido común: necesitan estar organizados en carpetas con etiquetas y de manera sistemática. Siempre de la misma manera datalib.edina.ac.uk/mantra/organisingdata/

Almacenarlos:depende un poco del entorno de la organización: servidores, ordenadores personales y portátiles, almacenamiento externo (longevidad no garantizada). - Documentar con metadatos ( información sobre nuestros datos)

- Analizar y visualizar: SPSS, STATA, SSAS Mathematica Todas de pago con licencias caras.

R y R Studio: acceso abierto. Se usa mucho en entornos científicos pero también en privados. Código abierto y crean sus propias librerías para hacer diferentes cosas.

Flexibilidad que no proporcionan otras herramientas.

ArcGIS. Atlas.ti. El primero es el más potente. Combinan datos con geolocalización. Datos cualitativos, vídeos, entrevistas, encuestas...

Gephi: le encanta: gráficos de redes con gran flexibilidad y potencia. Nodos, aristas y pesos de cada una.

Google Fusion Tables más sencillo de usar. Recomienda echar un vistazo. Ej. Artistas de la Fundación March desde 1973 que creó él.

Tableau un poco más accesible.

Infogr.am para infografías a partir de datos muy limpios.

Wordle también permite representaciones interesantes con términos. - Transformar e integrar

Pentaho: No se suele hablar de los procesos que generan los datos. De manera muy visual (saco datos de... y los proceso, los ordeno, divido, corto, analizo... Obtengo unos datos normalmente en .csv)

Python: Hay que programar. Es más fácil que Java.

ScraperWiki: scrapear páginas web: programas un robot y este descarga todas las páginas en las que estaba dividida y las une. Lo mismo con páginas pdf de las que no se saca la información fácilmente.

Open Refine: Limpiar y armonizar datos de manera sencilla. Muy potente. - Publicar y compartir.

IQSS Dataverse Network Repositorio de datos de Harvard y el MIT. Te permite crear tu repositorio en la nube en dos minutos. Muy bien pensada.

Menciona las licencias, en las que no se considera experto y nos dice que trabajar con datos en el futuro va a ser fundamental y puede ser un elemento diferenciador. Es hora de que desde las universidades hagamos algo y facilitemos el trabajo con datos a los investigadores, incluyendo la biblioteca.

En el turno de preguntas aseguraría que había que intentar atraer a la gente de otras especialidades. Por ejemplo a los estudiantes de estadística.

Javier de la Cueva nos dice que las normas cambian pero los conceptos no, que el Derecho es complicado pero muy plano ya que es muy pobre a la hora de hacerse preguntas. "Depende" es una de las máximas respuestas.

Plantea tres situaciones con datos:

- tarjetas opacas (el uso de determinadas tarjetas),

- Wikileaks: obtiene datos. En vez de usar los principales 5 periódicos puso la base de datos en línea. La descargaron los que sabían y hacían ahí las búsquedas.

- Entidades de gestión: obligación de publicar sus memorias anuales (están en sus páginas web). De 2008 a 2010 obtienen 224 millones canon por compensación por copia privada. Hay una sentencia de UE contra ello. El retraso en aplicarla supuso una pérdida de 64 millones y luego una ley establece que son irrecuperables.

Las tres tratan con datos y de cuestiones muy diferentes: datos que después tocan con privacidad, otros que implican al Estado y la seguridad nacional y un tercero que se refiere al control de uso de recursos públicos que se pagan a asociaciones privadas.

No hay definición legal de lo que es un dato. Sí que hay una ley de protección de datos. Y hay dos derechos que se están compartiendo: la propiedad intelectual ajena y la utilización de la propia propiedad.

La ley de PI regula obras: no regularía los datos. Sí establece un derecho sobre las bases de datos, derecho sui generis que intenta proteger la inversión que haya realizado el creador de la base de datos.

Es indiferente si algo es ilegal o no. El juez tal vez responderá después de varios años. Se da lo que llama un matonismo procesal, lo que viene a querer decir que cuando nos enfrentamos a la industria de contenidos tenemos que considerar lo que seamos capaz de resistir.

La RISP es otra. Existen dos tendencias: en USA se pone todo en línea porque se considera que las industrias crearán riqueza y se obtendrán ingresos mediante impuestos; en Europa se aplica una tasa y luego si hay impuestos sobre valor añadido los tendremos también.

Estas bases de datos las producimos nosotros. Podemos hacer scraping con el BOE y preguntar cuántos reglamentos se han publicado con Rajoy, cómo suben las regulaciones hacia el final del año? Se convierte en un acto político y de control del poder: dejamos la regulación jurídica estricta y lo convertimos en la posibilidad de un nuevo control por parte de los gobernados. Cuando tenemos los datos los publicamos... No voy a conceder que he extraído nada, pero le doy los scripts que he conseguido.

Se enfrentan casos singulares frente a cuestiones generales como las leyes.

Asegura que Tales de Mileto ya se enfrentó al problema de los big data: tenía muchos datos y no puede interpretarlos de acuerdo con la opción disponible: el mito. Por lo que acaba creando el logos. Los datos y las herramientas para tratarlos son la clave. Todo esto es la base para construir nuevos mundos.

Hay dos realidades: una que existamos o no seguirá existiendo. Otra (u otras) que no existe si no existimos, como las hipotecas, o la ciencia.

El OA es de 1665 con la publicación de la Royal Society. Es algo público y nos tiene que permitir un lenguaje sobre lo público. Luis nos ha mencionado algo esencial: la refutabilidad. Un mundo que se sostiene o no se sostiene. Las consecuencias se escapan a las meras regulaciones jurídicas.

Tenemos un proyecto común como universalidad. ¿Por qué es importante todo esto? Porque jugar con los datos es el primer escalón, luego se juega con los conceptos (open science) y de ahí al Open Access, que es sobre el que se podrá construir el Open Government. Se consigue con el Procomún, los bienes que son de todos y de nadie. El orden alfabético lo es (aunque hoy sería patentable en USA). Fonemas y grafemas los que más riqueza han generado. Serían también patentables, lo que muestra el disparate de la legislación.

Hay dos tipos de protección: excluir los bienes del uso ajeno o compartir lo máximo posible (cuanto más compartido más protegidos están).

Sloan Foundation establece 10 criterios sobre los datos [me falta uno]:

- datos completos

- datos primarios (más cercanos a investigación)

- oportunidad (lo antes posibles)

- facilidad de acceso físico y electrónico

- legibles por máquinas (no pdf que sea escaneados)

- no discriminación de acceso

- utilización de datos abiertos (no software derivativo o licencia jurídica)

- permanencia (poderlos encontrar a lo largo del tiempo)

- costes de uso (el menor posible y sin trasladar al usuario).

La ley no es como las Matemáticas. Derechos digitales con respecto al OA en las universidades. Nuevos sistemas de gobernanza en la OKF y similares.

Vertebrar la sociedad con mejores contenidos de gobernanza. Extraños derechos de remuneración.

En la propiedad intelectual siempre se han distinguido derechos morales y derechos de explotación. Estos son reproducción, distribución, transformación y comunicación pública. Si soy parte interesada y se me escapa el negocio por un lado, creo situaciones por otro. Con el marco del 4% del PIB pertenece a Cultura (esa mentira incluye el fútbol, los toros, las televisiones, etc.) crean un canon a universidades por tener campus virtual. Y llegan y dicen que las universidades son piratas, que tienen obras suyas. Usted tiene 18.000 socios y nosotros 130.000 profesores. Dicen que tienen al 90% de editoriales (y como mucho llega al 15%).

Editores centrados en el mundo del papel. En 2004 CEDRO modifica sus estatutos para gestionar los derechos digitales de los autores. Todos los contratos en los que no haya cesión de derechos digitales no pueden ser traspasados a CEDRO. 5 euros por alumno. Y las propias universidades tampoco le han cedido esos derechos. Algunas han acabado pactando.

Lo que hace el Ministerio es adjudicarle el derecho a CEDRO por ley cuando haya Campus Virtual. Derecho irrenunciable del autor a cobrar pero ese cobro se encarga a CEDRO. Criterios estadísticos secretos de reparto. Detrás de CEDRO, Planeta y televisiones.

Lo mejor que puede pasarle a la cultura es que desaparezca.

No se puede quitar al autor el derecho de ceder a la universalidad nuestras creaciones, que son resultado de lo que ya existía antes.

Juan Pavón nos habla del Plan de gestión de datos en Horizon2020 que se añade a la solicitud de la UE de hacer la publicación de los datos de la investigación en abierto. Existe un Programa Piloto con 7 áreas que se ha visto por la mañana.

En definitiva, Debemos hacer un plan de gestión de datos (PGD) en el que se especifiquen qué datos, qué metodología y normas, cómo y si se van a compartir y poner en abierto y cómo se van a preservar. Debe ir acompañado de metadatos y se contemplan datos que no se incluyen por cuestiones de privacidad, oportunidad, etc.

Menciona las ventajas para los investigadores para continuar comentando que en 6 meses hay que presentar un primer plan de datos y que el plan de gestión de datos cambia, está vivo, puede ser modificado a medida que se progresa. Para conseguirlo existen ayudas como la Plantilla ICPSR Data Managemente and Curation y herramientas sencillas para crear planes de gestión de datos (dmponline.dcc.ac.uk) que lo dan todo hecho para Horizon 2020: nos permite crear el plan inicial el final y el intermedio o de seguimiento. De ahí que no es tan difícil crear un plan de gestión de datos porque tenemos herramientas que nos ayudan.